ASRock Rack, Asus, Gigabyte, Pegatron, QCT dan Supermicro akan mengadopsi MGX, yang dapat memangkas biaya pengembangan hingga tiga perempat dan mengurangi waktu pengembangan hingga dua pertiga menjadi hanya enam bulan.

“Perusahaan mencari opsi komputasi yang lebih cepat saat merancang pusat data yang memenuhi kebutuhan bisnis dan aplikasi khusus mereka,” kata Kaustubh Sanghani, wakil presiden produk GPU di Nvidia.

“Kami menciptakan MGX untuk membantu organisasi mem-bootstrap AI perusahaan, sekaligus menghemat banyak waktu dan uang.”

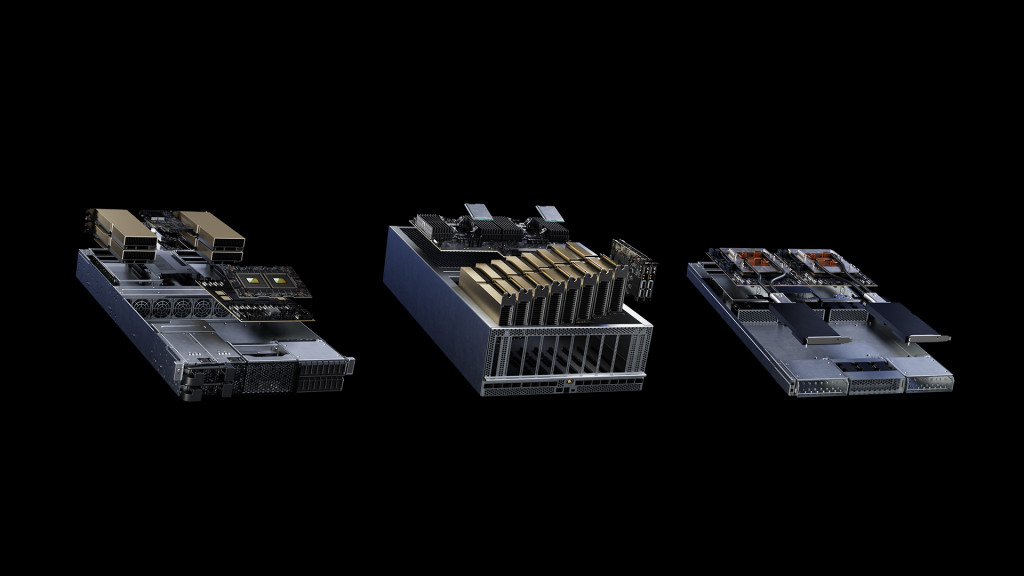

Dengan MGX, pabrikan memulai dengan arsitektur sistem dasar yang dioptimalkan untuk komputasi yang dipercepat untuk sasis server, lalu memilih GPU, DPU, dan CPU mereka. Variasi desain dapat mengatasi beban kerja yang unik, seperti HPC, ilmu data, model bahasa besar, komputasi edge, grafik dan video, AI perusahaan, serta desain dan simulasi.

Beberapa tugas seperti pelatihan AI dan 5G dapat ditangani pada satu mesin, sementara peningkatan ke generasi perangkat keras masa depan dapat berjalan mulus. MGX juga dapat dengan mudah diintegrasikan ke dalam cloud dan pusat data perusahaan.

QCT dan Supermicro akan menjadi yang pertama tersedia di pasar, dengan desain MGX muncul pada bulan Agustus. Sistem ARS-221GL-NR Supermicro, yang diumumkan hari ini, akan menyertakan Superchip CPU Nvidia Grace, sementara sistem S74G-2U QCT, yang juga diumumkan hari ini, akan menggunakan Superchip Grace Hopper Nvidia GH200.

Selain itu, SoftBank berencana meluncurkan beberapa pusat data hyperscale di seluruh Jepang dan menggunakan MGX untuk mengalokasikan sumber daya GPU secara dinamis antara AI generatif dan aplikasi 5G.

“Ketika AI generatif meresap ke seluruh bisnis dan gaya hidup konsumen, membangun infrastruktur yang tepat dengan biaya yang tepat adalah salah satu tantangan terbesar operator jaringan,” kata Junichi Miyakawa, presiden dan CEO di SoftBank Corp. “Kami berharap Nvidia MGX dapat mengatasi tantangan tersebut. dan memungkinkan AI multi guna, 5G, dan lainnya tergantung pada persyaratan beban kerja waktu nyata.”

Pusat data semakin harus memenuhi persyaratan untuk meningkatkan kemampuan komputasi dan mengurangi emisi karbon demi memerangi perubahan iklim, sekaligus menekan biaya.

Server komputasi yang dipercepat dari Nvidia telah lama memberikan kinerja komputasi dan efisiensi energi yang luar biasa. Sekarang, desain modular MGX memberi pabrikan sistem kemampuan untuk secara lebih efektif memenuhi anggaran khusus, pengiriman daya, desain termal, dan persyaratan mekanis setiap pelanggan.

MGX berbeda dari Nvidia HGX karena menawarkan kompatibilitas multi-generasi yang fleksibel dengan produk Nvidia untuk memastikan bahwa pembuat sistem dapat menggunakan kembali desain yang ada dan dengan mudah mengadopsi produk generasi berikutnya tanpa desain ulang yang mahal. Sebaliknya, HGX didasarkan pada baseboard multi-GPU yang terhubung dengan NVLink yang disesuaikan dengan skala untuk menciptakan sistem AI dan HPC terbaik.

Selain perangkat keras, MGX didukung oleh kumpulan perangkat lunak lengkap NVIDIA, yang memungkinkan pengembang dan perusahaan membangun dan mempercepat AI, HPC, dan aplikasi lainnya.

Ini termasuk Nvidia AI Enterprise, lapisan perangkat lunak platform Nvidia AI, yang menampilkan lebih dari 100 kerangka kerja, model yang telah dilatih sebelumnya, dan alat pengembangan untuk mempercepat AI dan ilmu data untuk pengembangan dan penyebaran AI perusahaan yang didukung penuh.

MGX kompatibel dengan rak server Open Compute Project dan Electronic Industries Alliance, untuk integrasi cepat ke pusat data perusahaan dan cloud.

Cek Berita dan Artikel yang lain di

Google News