Setelah sebelumnya digunakan untuk inference, kini NVFP4 diperluas untuk tahap pretraining model bahasa besar (LLM), yang menjadi langkah besar dalam meningkatkan efisiensi pelatihan AI skala masif.

Inovasi ini hadir di tengah meningkatnya beban kerja AI dan kebutuhan untuk memproses jumlah token yang semakin besar, dengan throughput menjadi faktor strategis bagi “pabrik AI” dalam mengembangkan model generasi berikutnya. Pretraining dengan presisi 4-bit bukanlah hal mudah karena memerlukan penanganan hati-hati terhadap gradien dan pembaruan parameter agar akurasi tetap terjaga.

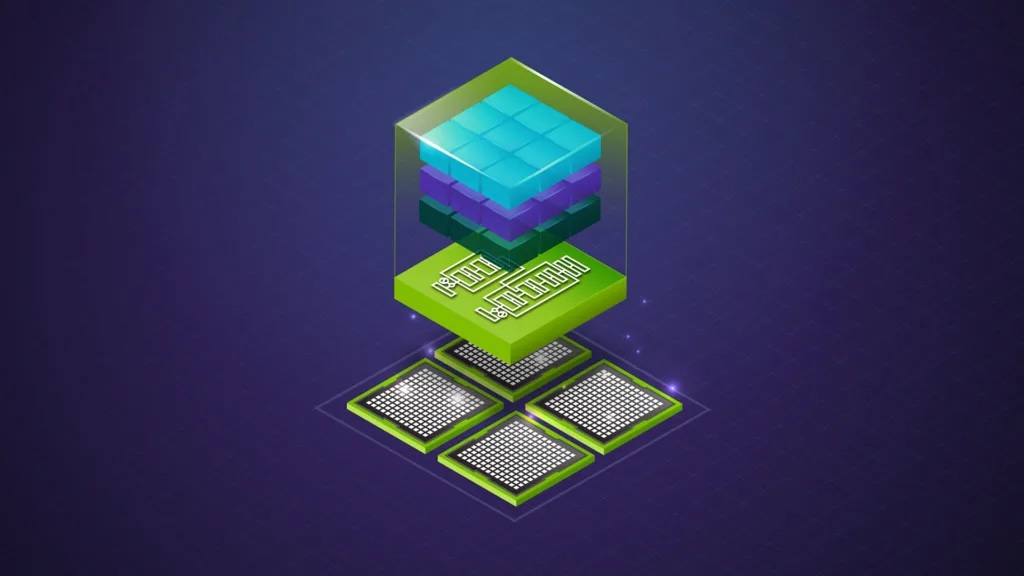

NVIDIA mengembangkan resep kuantisasi khusus untuk NVFP4 yang mencakup micro-block scaling pada kelompok 16 elemen untuk mengurangi kesalahan kuantisasi, penggunaan skala presisi tinggi E4M3 untuk representasi nilai yang lebih akurat, transformasi Hadamard untuk menghaluskan distribusi tensor, kuantisasi berbasis blok 2D selektif untuk menjaga konsistensi antara forward dan backward pass, serta stochastic rounding untuk mengurangi bias pembulatan dan menjaga aliran gradien.

Arsitektur Blackwell (GPU GB200/GB300) menjadi yang pertama mendukung FP4 secara native, memungkinkan percepatan hingga tujuh kali lipat pada operasi perkalian matriks dibanding generasi sebelumnya.

Hal ini sangat penting karena operasi tersebut merupakan inti dari pelatihan LLM. Dengan dukungan ini, proses pretraining dapat berjalan lebih cepat, hemat daya, dan memungkinkan eksperimen dalam skala lebih besar.

Pengujian dilakukan pada model Hybrid Mamba-Transformer berparameter 12 miliar yang dilatih dengan 10 triliun token. Hasilnya menunjukkan bahwa NVFP4 mampu mencapai kurva validation loss yang hampir identik dengan FP8, tanpa masalah stabilitas yang biasanya muncul pada pelatihan presisi sangat rendah.

Kinerja pada berbagai tugas downstream juga setara dengan model FP8, membuktikan bahwa NVFP4 dapat digunakan untuk pretraining skala triliun token tanpa mengorbankan akurasi.

Dengan efisiensi komputasi yang ditawarkan, NVFP4 membuka peluang bagi pengembangan model AI yang lebih besar, lebih cepat, dan lebih hemat energi. Teknologi ini masih dalam tahap riset, namun telah menarik kolaborasi dari berbagai perusahaan besar seperti AWS, Google Cloud, Microsoft AI, OpenAI, Cohere, dan lainnya.

Jika diadopsi secara luas, NVFP4 berpotensi menjadi standar baru dalam pelatihan AI generasi mendatang, mempercepat inovasi dan memperluas batas kemampuan pabrik AI.

Cek Berita dan Artikel yang lain di

Google News