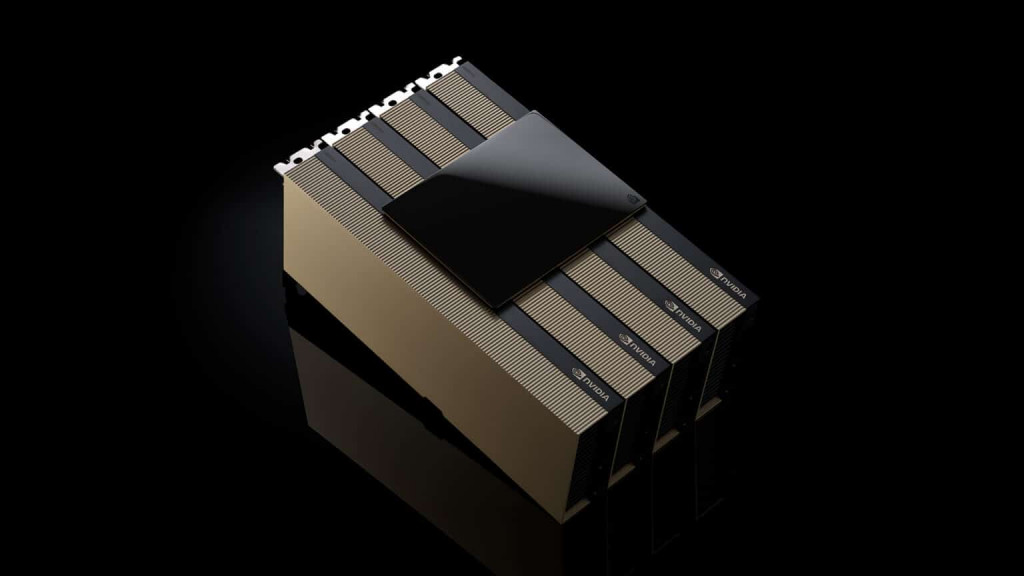

Selama konferensi Supercomputing 2024, NVIDIA mengumumkan ketersediaan GPU H200 NVL PCIe — tambahan terbaru untuk keluarga Hopper. H200 NVL ideal untuk organisasi dengan pusat data yang mencari desain rak perusahaan berpendingin udara berdaya rendah dengan konfigurasi fleksibel untuk memberikan akselerasi untuk setiap beban kerja AI dan HPC, apa pun ukurannya.

Menurut survei baru-baru ini, sekitar 70% rak perusahaan berukuran 20kW ke bawah dan menggunakan pendingin udara. Hal ini membuat GPU PCIe penting, karena memberikan perincian penerapan node, baik menggunakan satu, dua, empat, atau delapan GPU — memungkinkan pusat data mengemas lebih banyak daya komputasi ke ruang yang lebih kecil. Perusahaan kemudian dapat menggunakan rak yang ada dan memilih jumlah GPU yang paling sesuai dengan kebutuhan mereka.

Perusahaan dapat menggunakan H200 NVL untuk mempercepat aplikasi AI dan HPC, sekaligus meningkatkan efisiensi energi melalui pengurangan konsumsi daya. Dengan peningkatan memori 1,5x dan peningkatan bandwidth 1,2x dibandingkan H100 NVL, perusahaan dapat menggunakan H200 NVL untuk menyempurnakan LLM dalam beberapa jam dan memberikan kinerja inferensi hingga 1,7x lebih cepat. Untuk beban kerja HPC, performa ditingkatkan hingga 1,3x dibandingkan H100 NVL dan 2,5x dibandingkan generasi arsitektur Ampere.

Melengkapi kekuatan mentah H200 NVL adalah teknologi NVLink. NVLink generasi terbaru menyediakan komunikasi GPU-ke-GPU 7x lebih cepat daripada PCIe generasi kelima — memberikan kinerja yang lebih tinggi untuk memenuhi kebutuhan HPC, inferensi model bahasa besar, dan penyempurnaan.

NVIDIA H200 NVL dipasangkan dengan alat perangkat lunak canggih yang memungkinkan perusahaan mempercepat aplikasi dari AI ke HPC. Muncul dengan langganan lima tahun untuk AI Enterprise, platform perangkat lunak cloud-native untuk pengembangan dan penyebaran AI produksi.

Dengan H200 NVL, NVIDIA menyediakan platform full-stack bagi perusahaan untuk mengembangkan dan menerapkan beban kerja AI dan HPC mereka.

Pelanggan melihat dampak yang signifikan untuk beberapa kasus penggunaan AI dan HPC di seluruh industri, seperti agen AI visual dan chatbot untuk layanan pelanggan, algoritme perdagangan untuk keuangan, pencitraan medis untuk deteksi anomali yang lebih baik dalam perawatan kesehatan, pengenalan pola untuk manufaktur, dan pencitraan seismik untuk organisasi sains federal.

Dropbox memanfaatkan komputasi yang dipercepat NVIDIA untuk layanan dan infrastrukturnya.

"Dropbox menangani konten dalam jumlah besar, yang membutuhkan kemampuan AI dan pembelajaran mesin yang canggih," kata Ali Zafar, VP of Infrastructure di Dropbox. "Kami sedang mengeksplorasi H200 NVL untuk terus meningkatkan layanan kami dan membawa nilai lebih bagi pelanggan kami."

University of New Mexico telah menggunakan komputasi akselerasi NVIDIA dalam berbagai penelitian dan aplikasi akademik.

"Sebagai universitas riset publik, komitmen kami terhadap AI memungkinkan universitas untuk berada di garis depan kemajuan ilmiah dan teknologi," kata Prof. Patrick Bridges, direktur Pusat UNM untuk Komputasi Penelitian Lanjutan. "Saat kami beralih ke H200 NVL, kami akan dapat mempercepat berbagai aplikasi, termasuk inisiatif ilmu data, penelitian bioinformatika dan genomik, simulasi fisika dan astronomi, pemodelan iklim, dan banyak lagi."

Dell Technologies, Hewlett Packard Enterprise, Lenovo dan Supermicro diharapkan dapat memberikan berbagai konfigurasi yang mendukung H200 NVL. Selain itu, H200 NVL akan tersedia di platform dari Aivres, ASRock Rack, Asus, Gigabyte, Ingrasys, Inventec, MSI, Pegatron, QCT, Wistron dan Wiwynn.

Beberapa sistem didasarkan pada arsitektur modular NVIDIA MGX, yang memungkinkan pembuat komputer membangun beragam desain infrastruktur pusat data dengan cepat dan hemat biaya.

Platform dengan H200 NVL akan tersedia dari mitra sistem global NVIDIA mulai bulan Desember. Untuk melengkapi ketersediaan dari mitra global terkemuka, NVIDIA juga mengembangkan Arsitektur Referensi Perusahaan untuk sistem H200 NVL.

Arsitektur referensi akan menggabungkan keahlian dan prinsip desain NVIDIA, sehingga mitra dan pelanggan dapat merancang dan menerapkan infrastruktur AI berkinerja tinggi berdasarkan H200 NVL dalam skala besar.

Ini termasuk rekomendasi perangkat keras dan perangkat lunak tumpukan penuh, dengan panduan terperinci tentang konfigurasi server, klaster, dan jaringan yang optimal. Jaringan dioptimalkan untuk kinerja tertinggi dengan platform NVIDIA Spectrum-X Ethernet.

Cek Berita dan Artikel yang lain di

Google News