Arsitektur MoE kini menjadi standar baru bagi model AI paling canggih. Menurut NVIDIA, 10 model open‑source paling cerdas di leaderboard Artificial Analysis—termasuk DeepSeek‑R1, Kimi K2 Thinking, dan Mistral Large 3—seluruhnya menggunakan pendekatan MoE.

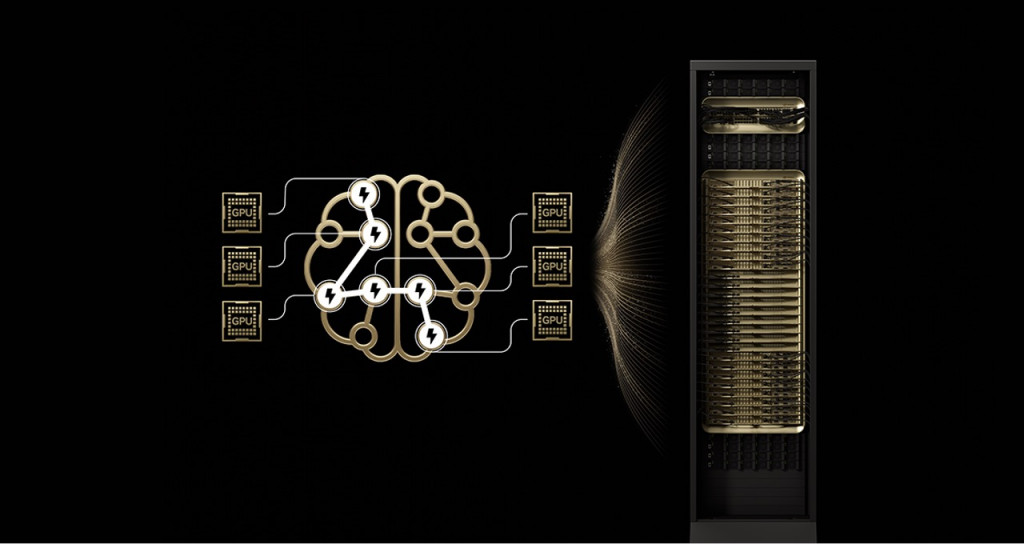

Arsitektur ini bekerja dengan mengaktifkan hanya pakar yang relevan untuk setiap token, mirip cara otak manusia mengaktifkan area tertentu sesuai tugas. Hasilnya, model dapat menghasilkan keluaran lebih cepat dan efisien tanpa harus mengaktifkan seluruh parameter yang jumlahnya bisa mencapai ratusan miliar.

Namun, MoE bukan tanpa tantangan. Model-model ini terlalu besar untuk dijalankan pada satu GPU, sehingga membutuhkan distribusi pakar ke banyak GPU. Pada platform sebelumnya seperti H200, hambatan muncul pada keterbatasan memori dan latensi komunikasi antar GPU, terutama ketika jumlah GPU melebihi delapan unit.

Di sinilah GB200 NVL72 menjadi solusi. Sistem ini menggabungkan 72 GPU Blackwell dalam satu rak yang bekerja seolah menjadi satu unit raksasa, dengan 1,4 exaflops performa AI dan 30 TB memori bersama. Seluruh GPU terhubung melalui NVLink Switch yang menyediakan bandwidth hingga 130 TB/s, memungkinkan komunikasi antar pakar berlangsung hampir instan.

Dengan desain ekstrem ini, beban memori per GPU berkurang drastis, sementara komunikasi antar pakar menjadi jauh lebih cepat. NVIDIA juga mengoptimalkan performa melalui teknologi seperti NVIDIA Dynamo, format presisi NVFP4, serta dukungan dari framework open‑source seperti TensorRT‑LLM, SGLang, dan vLLM.

Tak hanya itu, berbagai perusahaan besar mulai mengadopsi NVL72 untuk kebutuhan produksi. AWS, Google Cloud, Microsoft Azure, CoreWeave, hingga Oracle Cloud Infrastructure tercatat sebagai mitra yang akan menghadirkan sistem ini ke pelanggan global. Perusahaan seperti DeepL dan Fireworks AI bahkan sudah mulai memanfaatkan NVL72 untuk melatih dan menjalankan model generasi terbaru mereka.

NVIDIA menegaskan bahwa peningkatan performa ini bukan sekadar angka benchmark. Dengan efisiensi per watt yang meningkat 10 kali lipat, pusat data dapat menghasilkan pendapatan token yang jauh lebih besar dengan konsumsi daya yang sama. CEO NVIDIA Jensen Huang juga menyoroti bagaimana NVL72 memberikan performa 10 kali lebih tinggi untuk model DeepSeek‑R1 dan variannya.

Ke depan, NVIDIA melihat MoE sebagai fondasi bagi model multimodal dan sistem agentic yang semakin kompleks. Dengan roadmap menuju arsitektur NVIDIA Vera Rubin, perusahaan optimistis bahwa masa depan AI akan mengandalkan pendekatan pakar terdistribusi yang lebih efisien, terukur, dan hemat energi.

Cek Berita dan Artikel yang lain di

Google News