Melakukan urutan lintasan inferensi ini — menggunakan alasan untuk sampai pada jawaban terbaik — dikenal sebagai penskalaan waktu pengujian. DeepSeek-R1 adalah contoh sempurna dari hukum penskalaan ini, menunjukkan mengapa komputasi yang dipercepat sangat penting untuk tuntutan inferensi AI agen.

Karena model diizinkan untuk "berpikir" secara berulang melalui masalah, mereka menciptakan lebih banyak token keluaran dan siklus generasi yang lebih lama, sehingga kualitas model terus berkembang. Komputasi waktu pengujian yang signifikan sangat penting untuk memungkinkan inferensi real-time dan respons berkualitas lebih tinggi dari model penalaran seperti DeepSeek-R1, yang memerlukan penerapan inferensi yang lebih besar.

R1 memberikan akurasi terdepan untuk tugas-tugas yang menuntut inferensi logis, penalaran, matematika, pengkodean, dan pemahaman bahasa sekaligus memberikan efisiensi inferensi yang tinggi.

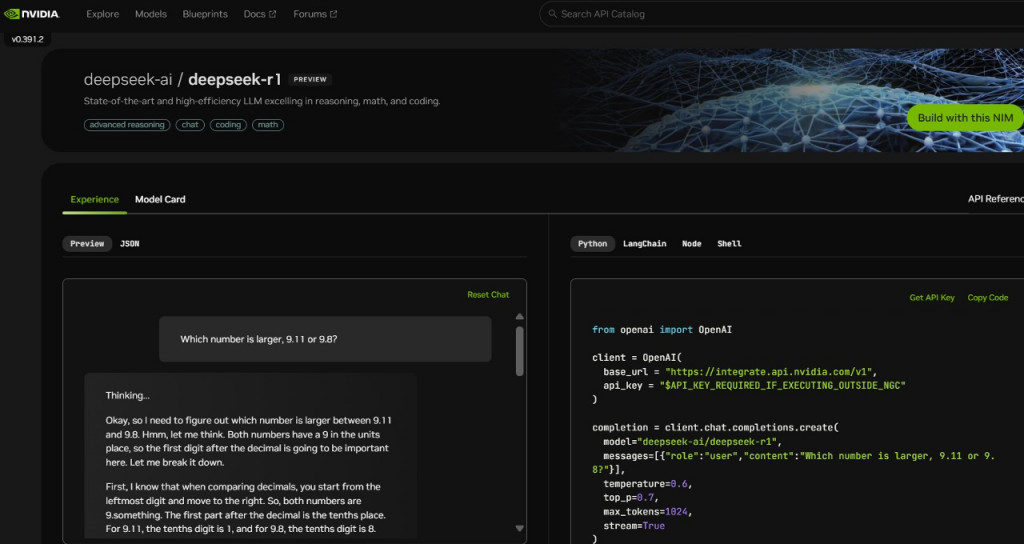

Untuk membantu pengembang bereksperimen dengan aman dengan kemampuan ini dan membangun agen khusus mereka sendiri, model DeepSeek-R1 dengan 671 miliar parameter sekarang tersedia sebagai pratinjau layanan mikro NVIDIA NIM. Layanan mikro NIM DeepSeek-R1 dapat mengirimkan hingga 3.872 token per detik pada satu sistem NVIDIA HGX H200.

Pengembang dapat menguji dan bereksperimen dengan antarmuka pemrograman aplikasi (API), yang diharapkan akan segera tersedia sebagai layanan mikro NIM yang dapat diunduh, bagian dari platform perangkat lunak NVIDIA AI Enterprise.

Layanan mikro NIM DeepSeek-R1 menyederhanakan penerapan dengan dukungan untuk API standar industri. Perusahaan dapat memaksimalkan keamanan dan privasi data dengan menjalankan layanan mikro NIM pada infrastruktur komputasi yang dipercepat pilihan mereka.

Dengan menggunakan NVIDIA AI Foundry dengan perangkat lunak NVIDIA NeMo, perusahaan juga akan dapat membuat layanan mikro DeepSeek-R1 NIM yang disesuaikan untuk agen AI khusus.

DeepSeek-R1 adalah model Large Mixture-of-Experts (MoE). Ini menggabungkan 671 miliar parameter yang mengesankan — 10x lebih banyak dari banyak LLM sumber terbuka populer lainnya — yang mendukung panjang konteks input yang besar sebesar 128.000 token. Model ini juga menggunakan jumlah ahli yang ekstrim per lapisan. Setiap lapisan R1 memiliki 256 ahli, dengan setiap token dirutekan ke delapan ahli terpisah secara paralel untuk evaluasi.

Memberikan jawaban real-time untuk R1 memerlukan banyak GPU dengan performa komputasi tinggi, terhubung dengan bandwidth tinggi dan komunikasi latensi rendah untuk merutekan token prompt ke semua ahli untuk inferensi.

Dikombinasikan dengan pengoptimalan perangkat lunak yang tersedia di layanan mikro NIM, satu server dengan delapan GPU H200 yang terhubung menggunakan NVLink dan NVLink Switch dapat menjalankan model DeepSeek-R1 penuh dengan parameter 671 miliar hingga 3.872 token per detik. Throughput ini dimungkinkan dengan menggunakan FP8 Transformer Engine arsitektur Hopper di setiap lapisan — dan bandwidth NVLink 900 GB/s untuk komunikasi ahli MoE.

Mendapatkan setiap operasi floating point per detik (FLOPS) performa dari GPU sangat penting untuk inferensi real-time. Arsitektur Blackwell generasi berikutnya akan memberikan penskalaan waktu pengujian pada model penalaran seperti DeepSeek-R1 dorongan besar dengan Tensor Core generasi kelima yang dapat memberikan performa komputasi FP4 puncak hingga 20 petaflops dan domain NVLink 72-GPU yang secara khusus dioptimalkan untuk inferensi.

Cek Berita dan Artikel yang lain di

Google News