NVIDIA H200 adalah GPU pertama yang menawarkan HBM3e — memori lebih cepat dan lebih besar untuk mendorong percepatan AI generatif dan model bahasa besar, sekaligus memajukan komputasi ilmiah untuk beban kerja HPC.

Dengan HBM3e, NVIDIA H200 menghadirkan memori 141GB dengan kecepatan 4,8 terabyte per detik, kapasitasnya hampir dua kali lipat dan bandwidth 2,4x lebih besar dibandingkan pendahulunya, NVIDIA A100.

Sistem bertenaga H200 dari produsen server dan penyedia layanan cloud terkemuka dunia diperkirakan akan mulai dikirimkan pada kuartal kedua tahun 2024.

“Untuk menciptakan kecerdasan dengan AI generatif dan aplikasi HPC, data dalam jumlah besar harus diproses secara efisien dengan kecepatan tinggi menggunakan memori GPU yang besar dan cepat,” kata Ian Buck, wakil presiden hyperscale dan HPC di NVIDIA.

“Dengan NVIDIA H200, platform superkomputer AI end-to-end terdepan di industri menjadi lebih cepat dalam memecahkan beberapa tantangan paling penting di dunia.”

Arsitektur NVIDIA Hopper memberikan lompatan kinerja dibandingkan pendahulunya dan terus meningkatkan standar melalui penyempurnaan perangkat lunak yang berkelanjutan dengan H100, termasuk rilis terbaru perpustakaan sumber terbuka yang canggih seperti NVIDIA TensorRT-LLM.

Pengenalan H200 akan menghasilkan lompatan kinerja lebih lanjut, termasuk kecepatan inferensi hampir dua kali lipat pada Llama 2, LLM dengan 70 miliar parameter, dibandingkan dengan H100. Kepemimpinan dan peningkatan kinerja tambahan dengan H200 diharapkan terjadi pada pembaruan perangkat lunak di masa mendatang.

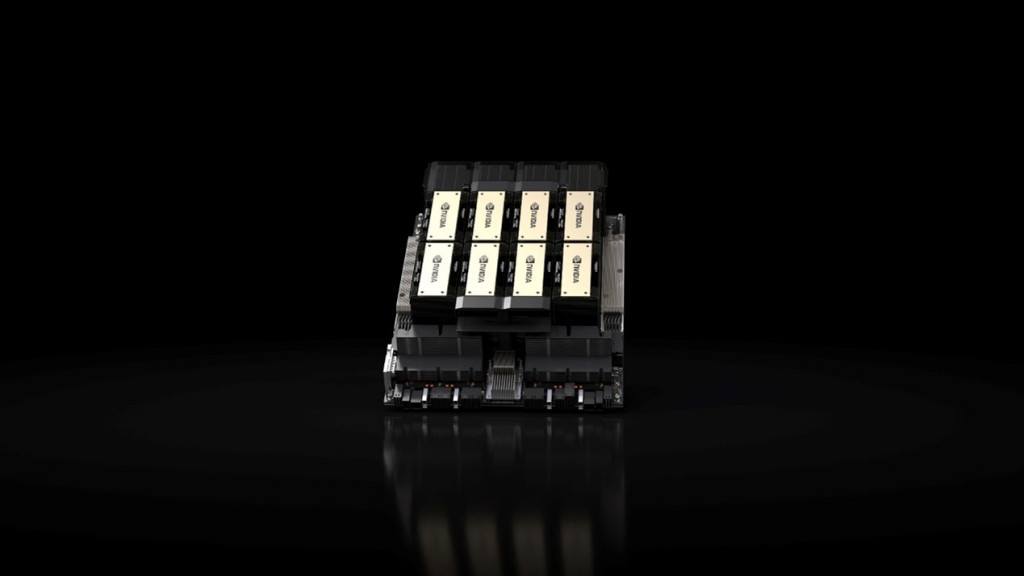

NVIDIA H200 akan tersedia dalam papan server NVIDIA HGX H200 dengan konfigurasi empat dan delapan arah, yang kompatibel dengan perangkat keras dan perangkat lunak sistem HGX H100. Ini juga tersedia di Superchip NVIDIA GH200 Grace Hopper dengan HBM3e, yang diumumkan pada bulan Agustus.

Dengan opsi ini, H200 dapat diterapkan di setiap jenis pusat data, termasuk on-premise, cloud, hybrid-cloud, dan edge. Ekosistem global pembuat server mitra NVIDIA — termasuk ASRock Rack, ASUS, Dell Technologies, Eviden, GIGABYTE, Hewlett Packard Enterprise, Ingrasys, Lenovo, QCT, Supermicro, Wistron dan Wiwynn — dapat memperbarui sistem mereka yang ada dengan H200.

Amazon Web Services, Google Cloud, Microsoft Azure, dan Oracle Cloud Infrastructure akan menjadi penyedia layanan cloud pertama yang menerapkan instans berbasis H200 mulai tahun depan, selain CoreWeave, Lambda, dan Vultr.

Didukung oleh interkoneksi berkecepatan tinggi NVIDIA NVLink dan NVSwitch, HGX H200 memberikan kinerja tertinggi pada berbagai beban kerja aplikasi, termasuk pelatihan LLM dan inferensi untuk model terbesar yang melampaui 175 miliar parameter.

HGX H200 delapan arah menyediakan lebih dari 32 petaflops komputasi pembelajaran mendalam FP8 dan 1,1TB memori bandwidth tinggi agregat untuk kinerja tertinggi dalam aplikasi AI generatif dan HPC.

Saat dipasangkan dengan CPU NVIDIA Grace dengan interkoneksi NVLink-C2C yang sangat cepat, H200 menciptakan GH200 Grace Hopper Superchip dengan HBM3e — modul terintegrasi yang dirancang untuk melayani aplikasi HPC dan AI skala besar.

NVIDIA H200 akan tersedia dari produsen sistem global dan penyedia layanan cloud mulai kuartal kedua tahun 2024.

Cek Berita dan Artikel yang lain di

Google News