Selain itu, benchmark Llama 2 70B Interactive juga diperbarui dengan persyaratan latensi yang lebih ketat, mencerminkan tuntutan penerapan produksi yang membutuhkan pengalaman pengguna yang responsif.

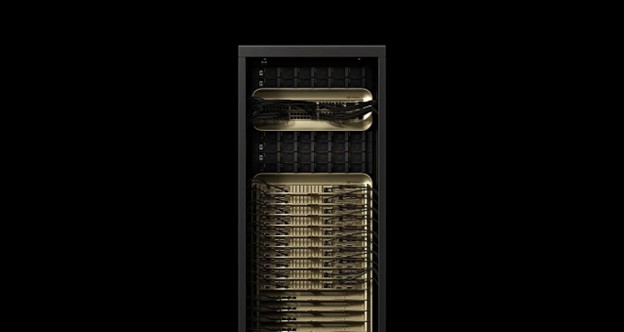

Sistem GB200 NVL72, yang menghubungkan 72 GPU NVIDIA Blackwell untuk beroperasi sebagai satu GPU raksasa, memberikan peningkatan throughput hingga 30 kali lipat pada benchmark Llama 3.1 405B dibandingkan dengan pengajuan NVIDIA H200 NVL8 pada putaran sebelumnya. Peningkatan signifikan ini dicapai melalui performa per GPU yang lebih dari tiga kali lipat dan domain NVLink yang sembilan kali lebih besar.

Dave Salvator, dalam blog NVIDIA, menjelaskan bahwa pencapaian ini menegaskan peran penting infrastruktur komputasi baru yang disebut "pabrik AI". Berbeda dengan pusat data tradisional, pabrik AI tidak hanya menyimpan dan memproses data, tetapi juga menghasilkan kecerdasan dalam skala besar dengan mengubah data mentah menjadi wawasan real-time. Tujuan utama pabrik AI adalah memberikan jawaban yang akurat terhadap pertanyaan dengan cepat, dengan biaya terendah, dan kepada sebanyak mungkin pengguna.

Kompleksitas untuk mencapai tujuan ini sangat besar. Seiring dengan pertumbuhan model AI menjadi miliaran dan triliunan parameter untuk memberikan jawaban yang lebih cerdas, komputasi yang diperlukan untuk menghasilkan setiap token juga meningkat.

Hal ini mengurangi jumlah token yang dapat dihasilkan oleh pabrik AI dan meningkatkan biaya per token. Menjaga throughput inferensi tetap tinggi dan biaya per token tetap rendah membutuhkan inovasi cepat di setiap lapisan tumpukan teknologi, mulai dari silikon, sistem jaringan, hingga perangkat lunak.

Benchmark Llama 2 70B Interactive yang baru memiliki TPOT (time per output token) 5 kali lebih pendek dan TTFT (time to first token) 4,4 kali lebih rendah, yang memodelkan pengalaman pengguna yang lebih responsif.

Pada tes ini, pengajuan NVIDIA menggunakan sistem NVIDIA DGX B200 dengan delapan GPU Blackwell melipatgandakan performa dibandingkan dengan menggunakan delapan GPU NVIDIA H200, menetapkan standar yang tinggi untuk versi benchmark Llama 2 70B yang lebih menantang ini.

Arsitektur NVIDIA Hopper, yang diperkenalkan pada tahun 2022, terus menjadi tulang punggung banyak pabrik inferensi AI saat ini, dan juga terus mendukung pelatihan model. Melalui optimalisasi perangkat lunak berkelanjutan, NVIDIA meningkatkan throughput pabrik AI berbasis Hopper, yang menghasilkan nilai yang lebih besar.

Pada benchmark Llama 2 70B, throughput GPU H100 telah meningkat 1,5 kali lipat, dan GPU H200, yang berbasis pada arsitektur GPU Hopper yang sama dengan memori GPU yang lebih besar dan lebih cepat, memperpanjang peningkatan tersebut menjadi 1,6 kali lipat.

Hopper juga menjalankan setiap benchmark, termasuk Llama 3.1 405B, Llama 2 70B Interactive, dan tes jaringan neural graf yang baru ditambahkan. Fleksibilitas ini berarti Hopper dapat menjalankan berbagai macam beban kerja dan tetap mengikuti perkembangan model dan skenario penggunaan yang semakin menantang.

Putaran MLPerf kali ini juga melibatkan 15 mitra yang mengajukan hasil yang luar biasa pada platform NVIDIA, termasuk Asus, Cisco, CoreWeave, Dell Technologies, Fujitsu, Giga Computing, Google Cloud, Hewlett Packard Enterprise, Lambda, Lenovo, Oracle Cloud Infrastructure, Quanta Cloud Technology (QCT), Supermicro, Sustainable Metal Cloud, dan VMware.

Cek Berita dan Artikel yang lain di

Google News