Para peneliti di Johns Hopkins dan Stanford Universities, mengungkapkan bahwa mereka telah mengintegrasikan model bahasa penglihatan (VLM) – dilatih pada video bedah berjam-jam – dengan sistem bedah robot da Vinci yang banyak digunakan.

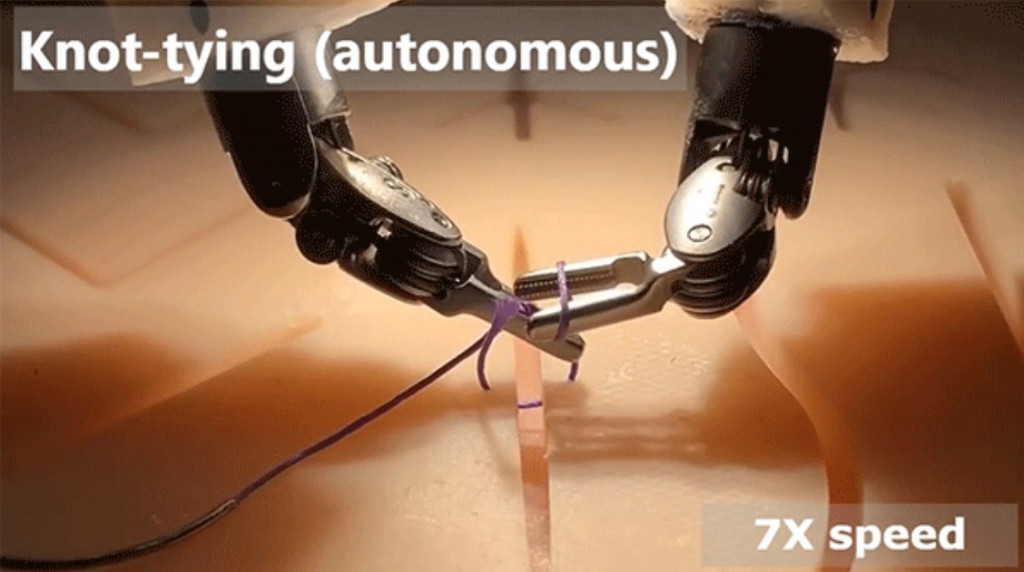

Setelah terhubung dengan VLM, grippers kecil da Vinci, atau "tangan", dapat secara mandiri melakukan tiga tugas bedah penting: mengangkat jaringan tubuh dengan hati-hati, menggunakan jarum bedah, dan menjahit luka.

Tidak seperti metode pelatihan robot tradisional—yang memerlukan pemrograman terperinci yang mencakup setiap bagian komponen gerakan robot—robot da Vinci yang dipasang kembali melakukan tugas bedah tanpa tembakan hanya dengan menggunakan pembelajaran imitasi. Hanya mengandalkan model bahasa penglihatannya, robot meniru apa yang telah dilakukan dokter dalam video bedah.

Hasilnya menawarkan gambaran sekilas tentang seperti apa kemungkinan operasi masa depan yang dilakukan sepenuhnya oleh robot otonom.

"Sungguh menakjubkan bahwa robot-robot ini sekarang dapat secara mandiri melakukan tugas-tugas yang sangat kompleks ini," kata Ji Woong "Brian" Kim, seorang peneliti pascadoktoral di Johns Hopkins.

"Robot pengkodean sehingga mereka benar-benar dapat beroperasi dari pembelajaran imitasi adalah perubahan paradigma besar dalam robotika dan, saya pikir, di mana masa depan terbentang untuk robot bedah otonom."

Untuk melatih model mereka, para peneliti menggunakan GPU NVIDIA GeForce RTX 4090, PyTorch, dan pustaka CUDA-X untuk AI.

Para peneliti mengungkapkan temuan mereka di Munich pada bulan November, di Konferensi Pembelajaran Robot. Untuk melakukan penelitian mereka, para ahli robot menggunakan sistem bedah robot da Vinci, yang dapat menampilkan hingga empat lengan robot dan digunakan oleh ahli bedah secara global untuk berbagai operasi laparoskopi.

Untuk melatih VLM mereka, Kim dan rekan-rekannya menghubungkan kamera video mini ke lengan tiga robot da Vinci yang dimiliki Universitas Johns Hopkins dan dipinjamkan kepada para peneliti untuk eksperimen mereka.

Dengan menggunakan bantalan silikon kecil yang biasanya digunakan dokter untuk mempraktikkan teknik bedah, Kim dan rekan-rekannya memanipulasi robot seperti yang dilakukan ahli bedah selama operasi laparoskopi.

Kim merekam sekitar 20 jam video dia memanipulasi grippers da Vinci — yang bersama-sama berukuran sekitar satu sen — untuk melakukan tiga prosedur: mengangkat faksimili jaringan manusia, memanipulasi jarum bedah, dan mengikat simpul dengan benang bedah.

Dia juga mencatat data kinematik yang relevan yang berkorelasi dengan manipulasi manual gripper. Data kinematik itu mencakup informasi yang tepat tentang sudut dan tekanan yang digunakan Kim saat memanipulasi robot selama setiap langkah bedah.

Setelah melatih VLM mereka dengan video bedah dan data kinematik, para peneliti menghubungkan model mereka dengan robot da Vinci dan menginstruksikan robot untuk melakukan tiga tugas bedah.

Para peneliti menjalankan eksperimen mereka pada potongan ayam dan babi—daging hewan yang belum pernah ditemui robot yang meniru tampilan dan nuansa jaringan manusia.

Salah satu kejutan, menurut Kim, adalah bagaimana robot secara mandiri memecahkan masalah tantangan yang tidak terduga.

Pada satu titik, gripper secara tidak sengaja menjatuhkan jarum bedah dan meskipun tidak pernah dilatih secara eksplisit untuk melakukannya, mengambilnya dan melanjutkan tugas bedahnya.

"Kami tidak pernah melatih model pada jaringan babi atau ayam, atau untuk mengambil jarum jika terjatuh," kata Kim. "Kami sangat senang itu bekerja di lingkungan yang benar-benar baru ini di luar distribusi pelatihannya dan dapat beroperasi secara mandiri."

Kim sudah mengerjakan makalah baru yang menguraikan hasil eksperimen yang lebih baru yang menyebarkan robot pada mayat hewan. Dia juga mengembangkan data pelatihan tambahan yang dapat digunakan untuk memperluas kemampuan robot da Vinci.

Cek Berita dan Artikel yang lain di

Google News