Platform ini menggabungkan tumpukan lengkap perangkat lunak inferensi NVIDIA dengan prosesor NVIDIA Ada, Hopper, dan Grace Hopper terbaru – termasuk GPU NVIDIA L4 Tensor Core dan GPU NVIDIA H100 NVL, dan keduanya diluncurkan hari ini.

Setiap platform dioptimalkan untuk beban kerja sesuai kebutuhan, termasuk video AI, pembuatan gambar, penerapan model bahasa besar, dan inferensi pemberi rekomendasi.

“Kebangkitan AI generatif membutuhkan platform komputasi yang lebih kuat,” kata Jensen Huang, Founder dan CEO NVIDIA.

“Aplikasi untuk AI generatif jumlahnya tidak terhingga, hanya dibatasi oleh imajinasi manusia. Mempersenjatai pengembang dengan platform komputasi yang paling kuat dan fleksibel akan mempercepat pembuatan layanan baru yang meningkatkan kehidupan kita dengan cara yang belum terbayangkan.”

Setiap platform berisi GPU NVIDIA yang dioptimalkan untuk beban kerja inferensi AI generatif tertentu serta perangkat lunak khusus:

1. NVIDIA L4 untuk AI Video dapat menghadirkan kinerja video bertenaga AI 120x lebih baik daripada CPU, dipadukan dengan efisiensi energi 99% lebih baik.

Melayani sebagai GPU universal untuk hampir semua beban kerja, ia menawarkan kemampuan decoding dan transcoding video yang ditingkatkan, streaming video, augmented reality, video AI generatif dan banyak lagi.

2. NVIDIA L40 untuk Pembuatan Gambar dioptimalkan untuk grafis dan pembuatan gambar 2D, video, dan 3D berkemampuan AI. L40 berfungsi sebagai mesin NVIDIA Omniverse, sebuah platform untuk membangun dan mengoperasikan aplikasi metaverse di data center, memberikan kinerja inferensi 7x untuk Difusi Stabil dan kinerja Omniverse 12x dari generasi sebelumnya.

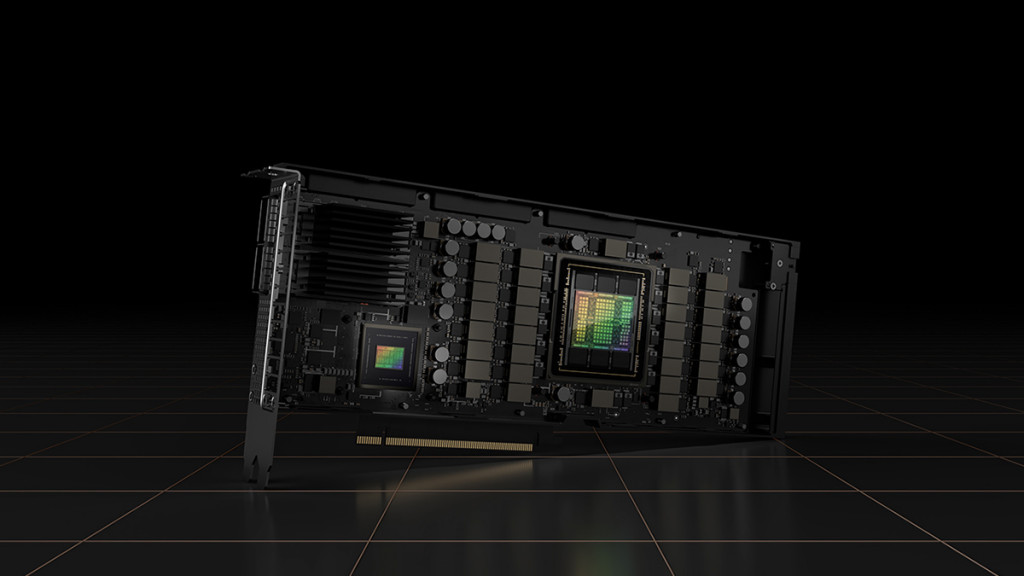

3. NVIDIA H100 NVL untuk Penerapan Model Bahasa Besar ideal untuk penerapan seperti ChatGPT dalam skala besar. H100 NVL baru dengan memori 94GB dengan akselerasi Transformer Engine memberikan kinerja inferensi hingga 12x lebih cepat pada GPT-3 dibandingkan dengan A100 generasi sebelumnya pada pusat data.

4. NVIDIA Grace Hopper untuk Model Rekomendasi cocok untuk model rekomendasi grafis, database vektor, dan jaringan neural grafis. Dengan koneksi NVLink-C2C 900 GB/s antara CPU dan GPU, Grace Hopper dapat memberikan transfer data dan kueri 7X lebih cepat dibandingkan dengan PCIe Gen 5.

Lapisan perangkat lunak platform ini menampilkan rangkaian aplikasi NVIDIA AI Enterprise, yang mencakup NVIDIA TensorRT, sebuah kit pengembangan perangkat lunak untuk inferensi pembelajaran mendalam berkinerja tinggi, dan NVIDIA Triton Inference Server™, sebuah perangkat lunak open source yang membantu standardisasi penerapan model.

Google Cloud adalah partner utama dan pelanggan awal platform inferensi NVIDIA. Ini mengintegrasikan L4 ke dalam platform pembelajaran mesinnya, Vertex AI, dan merupakan penyedia layanan cloud pertama yang menawarkan instans L4, dengan pratinjau terbatas dari mesin virtual G2 yang diluncurkan hari ini.

NVIDIA dan Google hari ini secara terpisah mengumumkan dua organisasi pertama yang memiliki akses awal ke L4 di Google Cloud – Descript, yang menggunakan AI generatif untuk membantu pembuat konten memproduksi video dan podcast, dan WOMBO, yang menawarkan teks bertenaga AI untuk aplikasi seni digital bernama Dream.

Pengadopsi awal lainnya, Kuaishou menyediakan aplikasi video pendek yang memanfaatkan GPU untuk mendekode video streaming langsung yang masuk, menangkap frame utama, dan mengoptimalkan audio video.

Ini kemudian menggunakan model skala besar berbasis transformator untuk memahami konten multi-modal dan meningkatkan rasio klik-tayang untuk ratusan juta pengguna secara global.

“Sistem rekomendasi Kuaishou melayani komunitas yang memiliki lebih dari 360 juta pengguna harian yang menyumbangkan 30 juta video UGC setiap hari,” kata Yue YU, Senior Vice President Kuaishou.

“Dibandingkan dengan CPU dengan total biaya kepemilikan yang sama, GPU NVIDIA telah meningkatkan throughput end-to-end sistem sebesar 11x, dan mengurangi latensi sebesar 20 persen.”

Cohere, pelopor terkemuka dalam bahasa AI, menjalankan platform yang memberdayakan pengembang untuk membangun model bahasa alami sekaligus menjaga privasi dan keamanan data.

“Platform inferensi H100 kinerja tinggi baru NVIDIA dapat memungkinkan kami untuk memberikan layanan yang lebih baik dan lebih efisien kepada pelanggan dengan model generatif yang canggih, mendukung berbagai aplikasi NLP seperti percakapan AI, pencarian perusahaan multibahasa, dan ekstraksi informasi, ”kata Aidan Gomez, CEO Cohere.

Terlepas dari Grace Hopper Superchip dan H100 NVL GPU, yang dijadwalkan hadir pada paruh kedua tahun ini, platform inferensi NVIDIA untuk AI generatif segera tersedia melalui jaringan pembuat komputer dan mitra penyedia layanan cloud NVIDIA di seluruh dunia.

GPU NVIDIA L4 tersedia dalam pratinjau terbatas di Google Cloud Platform dan juga tersedia dari jaringan global lebih dari 30 produsen komputer, termasuk Advantech, ASUS, Atos, Cisco, Dell Technologies, Fujitsu, Gigabyte, Hewlett Packard Enterprise, Lenovo, QCT, dan Supermicro.

Cek Berita dan Artikel yang lain di

Google News