Diperkenalkan pada awal 2026, Rubin menggabungkan enam chip baru dalam satu arsitektur terpadu yang diklaim mampu memangkas biaya dan waktu pelatihan serta inferensi AI secara signifikan.

Platform Rubin mengandalkan pendekatan extreme codesign yang menyatukan perangkat keras dan perangkat lunak, dengan target menurunkan biaya token inferensi hingga 10 kali lipat serta mengurangi kebutuhan GPU hingga empat kali lebih sedikit untuk melatih model mixture-of-experts (MoE), dibandingkan platform NVIDIA Blackwell.

Enam Chip dalam Satu Arsitektur Terpadu

Rubin terdiri dari enam komponen utama, yakni NVIDIA Vera CPU, NVIDIA Rubin GPU, NVLink 6 Switch, ConnectX-9 SuperNIC, BlueField-4 DPU, dan Spectrum-6 Ethernet Switch. Seluruh elemen tersebut dirancang untuk bekerja sebagai satu sistem superkomputer AI yang terintegrasi.Menurut NVIDIA, desain ini ditujukan untuk memenuhi lonjakan kebutuhan komputasi AI, baik untuk pelatihan model berskala besar maupun inferensi yang menuntut efisiensi tinggi dan latensi rendah.

“Rubin hadir di saat yang tepat, ketika permintaan komputasi AI untuk training dan inference meningkat pesat,” kata Jensen Huang, pendiri dan CEO NVIDIA. Ia menegaskan bahwa pendekatan codesign lintas enam chip menjadi lompatan besar menuju era baru superkomputer AI.

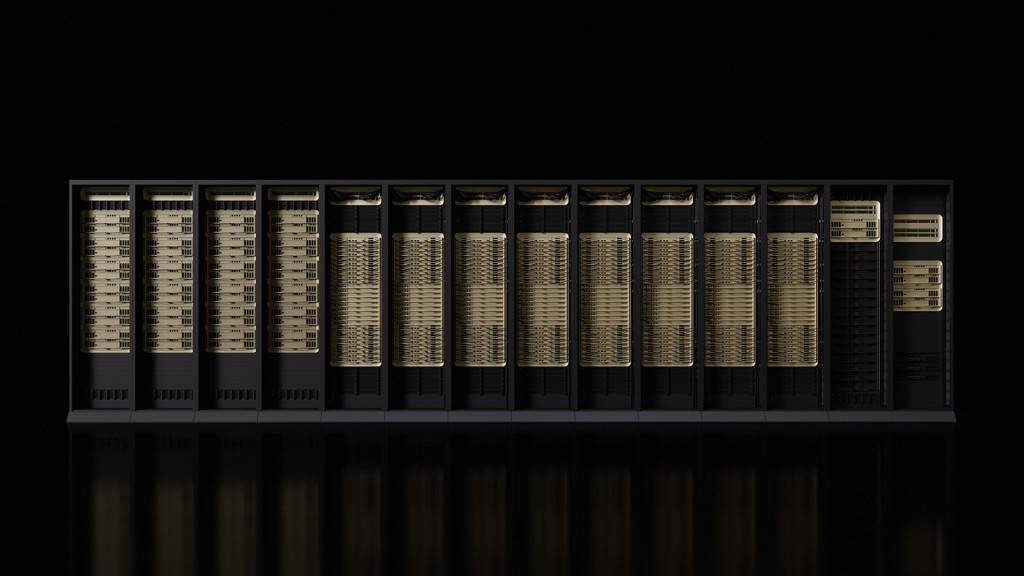

Nama Rubin diambil dari Vera Florence Cooper Rubin, astronom Amerika Serikat yang dikenal lewat kontribusinya dalam memahami struktur alam semesta. Platform ini mencakup solusi rak skala besar Vera Rubin NVL72 serta sistem HGX Rubin NVL8, yang dirancang untuk berbagai skenario pusat data dan AI factory.

NVIDIA menyebut Rubin membawa lima inovasi utama, termasuk generasi terbaru NVLink, Transformer Engine, Confidential Computing, RAS Engine, serta CPU Vera. Kombinasi ini memungkinkan akselerasi agentic AI, penalaran tingkat lanjut, dan inferensi MoE berskala masif dengan efisiensi biaya yang jauh lebih baik.

Dukungan Ekosistem Global

Rubin mendapat dukungan luas dari ekosistem industri, mulai dari penyedia cloud, pembuat server, hingga laboratorium AI terkemuka. Sejumlah perusahaan yang disebut akan mengadopsi platform ini antara lain Amazon Web Services, Microsoft, Google, Oracle, Meta, OpenAI, hingga xAI.Sam Altman, CEO OpenAI, menilai Rubin akan membantu skala komputasi AI agar model semakin canggih dan berdampak luas. Sementara itu, Satya Nadella menyebut Rubin sebagai fondasi penting bagi pengembangan AI superfactory generasi berikutnya di Microsoft.

Untuk mendukung model AI dengan konteks panjang dan penalaran bertahap, Rubin dibekali NVLink generasi keenam dengan bandwidth GPU hingga 3,6 TB/detik per GPU. Dalam konfigurasi rak NVL72, total bandwidth mencapai 260 TB/detik.

CPU Vera sendiri dirancang khusus untuk AI factory berskala besar dengan 88 core Olympus berbasis Armv9.2, serta konektivitas NVLink-C2C berkecepatan tinggi. Di sisi keamanan, Rubin menjadi platform rak pertama yang menghadirkan NVIDIA Confidential Computing lintas CPU, GPU, dan NVLink.

NVIDIA juga memperkenalkan Inference Context Memory Storage Platform berbasis BlueField-4 untuk mengelola konteks inferensi AI secara efisien. Platform ini memungkinkan berbagi dan penggunaan ulang key-value cache guna meningkatkan throughput dan responsivitas sistem AI.

Di sisi jaringan, Spectrum-6 Ethernet dan Spectrum-X Ethernet Photonics menawarkan efisiensi daya hingga lima kali lebih baik serta reliabilitas yang ditingkatkan, dirancang untuk AI factory berskala raksasa dan bahkan lingkungan multi-data center.

Kesiapan Produksi dan Jadwal Implementasi

NVIDIA menyatakan Rubin telah memasuki tahap produksi penuh. Produk berbasis Rubin akan tersedia melalui mitra pada paruh kedua 2026. Penyedia cloud seperti AWS, Google Cloud, Microsoft Azure, dan OCI dijadwalkan menjadi yang pertama menghadirkan instance berbasis Vera Rubin.Cek Berita dan Artikel yang lain di

Google News