AI Workbench diklaim menghilangkan kerumitan dalam memulai proyek AI perusahaan. Diakses melalui antarmuka yang disederhanakan yang berjalan pada sistem lokal, ini memungkinkan pengembang menyesuaikan model dari repositori populer seperti Hugging Face, GitHub, dan Nvidia NGC menggunakan data khusus, yang kemudian dapat dibagikan dengan mudah ke berbagai platform.

“Perusahaan di seluruh dunia berlomba untuk menemukan infrastruktur yang tepat dan membangun model dan aplikasi AI generatif,” kata Manuvir Das, wakil presiden komputasi perusahaan di Nvidia .

“Nvidia AI Workbench menyediakan jalur yang disederhanakan bagi tim lintas organisasi untuk membuat aplikasi berbasis AI yang semakin penting dalam bisnis modern.”

Sementara ratusan ribu model pra-pelatihan kini tersedia, menyesuaikannya dengan banyak alat open-source yang tersedia dapat menjadi tantangan dan menghabiskan waktu.

Proyek AI skala besar memerlukan pencarian melalui beberapa repositori online untuk kerangka kerja, alat, dan wadah yang tepat, dan menggunakan keahlian yang tepat untuk menyesuaikan model untuk kasus penggunaan tertentu. Memindahkan proyek itu dari satu infrastruktur komputasi ke infrastruktur lain memerlukan memulai proses dari awal lagi.

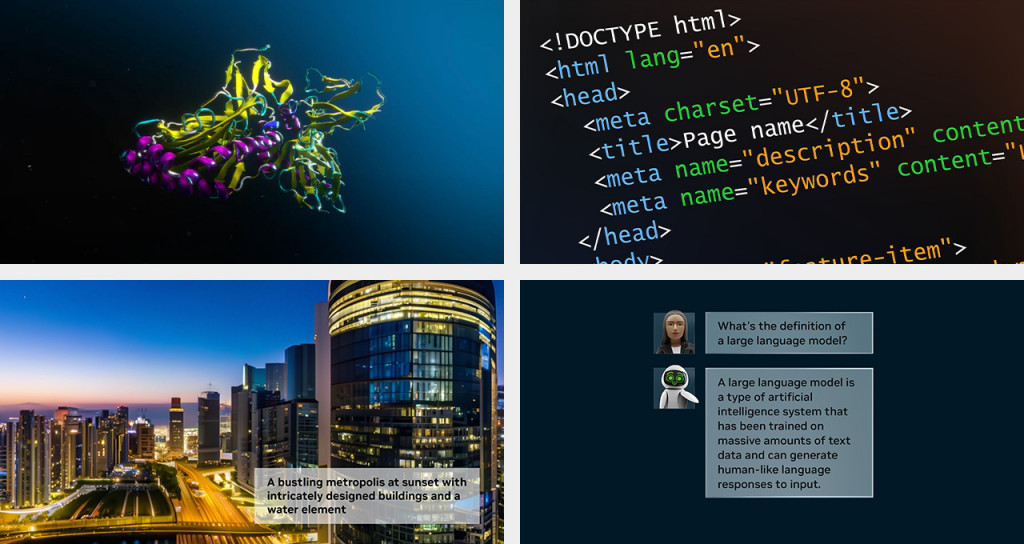

Dengan Nvidia AI Workbench, pengembang dapat menyesuaikan dan menjalankan AI generatif hanya dengan beberapa klik. Ini memungkinkan mereka menggabungkan semua model, kerangka kerja, SDK, dan pustaka tingkat perusahaan yang diperlukan dari repositori sumber terbuka dan platform Nvidia AI ke dalam ruang kerja pengembang terpadu.

Untuk lebih mempercepat adopsi AI generatif, Nvidia mengumumkan versi terbaru dari platform perangkat lunak perusahaannya, Nvidia AI Enterprise 4.0. Ini memberi bisnis akses ke alat yang diperlukan untuk mengadopsi AI generatif, sekaligus menawarkan keamanan dan stabilitas API yang diperlukan untuk penerapan produksi yang andal.

Perangkat lunak dan alat yang baru didukung di Nvidia AI Enterprise yang membantu merampingkan penerapan AI generatif meliputi Nvidia NeMo, kerangka kerja cloud-native untuk membuat, menyesuaikan, dan menerapkan LLM. Dengan NeMo, Nvidia AI Enterprise memberikan dukungan end-to-end untuk membuat dan menyesuaikan aplikasi LLM.

Nvidia Triton Management Service, yang membantu mengotomatiskan dan mengoptimalkan penerapan produksi. Hal ini memungkinkan perusahaan untuk secara otomatis menerapkan beberapa instance Nvidia Triton Inference Server di Kubernetes dengan orkestrasi model untuk pengoperasian AI yang dapat diskalakan secara efisien.

Perangkat lunak manajemen klaster Nvidia Base Command Manager Essentials membantu perusahaan memaksimalkan kinerja dan pemanfaatan server AI di seluruh pusat data, lingkungan multi-cloud dan hybrid-cloud.

Perangkat lunak Nvidia AI Enterprise -- yang memungkinkan pengguna membangun dan menjalankan solusi yang mendukung Nvidia AI di seluruh cloud, pusat data, dan edge – telah tersertifikasi untuk berjalan di sistem mainstream, Nvidia DGX, semua platform cloud utama dan Workstation Nvidia RTX yang baru saja diumumkan.

Perusahaan perangkat lunak terkemuka ServiceNow dan Snowflake baru-baru ini mengumumkan bahwa mereka bermitra dengan Nvidia untuk mengaktifkan AI generatif di platform mereka. Integrasi Nvidia AI Enterprise 4.0 dan Nvidia NeMo menyediakan landasan untuk solusi AI generatif siap produksi bagi pelanggan.

Cek Berita dan Artikel yang lain di

Google News