Red Hat AI Inference Server merupakan bagian dari portofolio Red Hat AI dan tersedia sebagai solusi mandiri yang terkontainerisasi, atau sebagai komponen terintegrasi dalam Red Hat Enterprise Linux AI (RHEL AI) dan Red Hat OpenShift AI.

Didukung oleh teknologi vLLM dari komunitas open source dan diperkuat oleh Neural Magic, Red Hat menyuguhkan server inferensi AI dengan performa tinggi yang hemat biaya dan fleksibel dalam pemilihan model, akselerator, maupun lingkungan komputasi.

Meningkatkan Kinerja Inferensi di Era AI Generatif

Inferensi adalah jantung dari AI generatif, titik di mana model AI yang telah dilatih menerjemahkan data menjadi pengalaman nyata yang dihadapi pengguna. Dalam skenario industri yang makin kompleks, beban kerja inferensi kerap menghambat kinerja sistem karena tingginya konsumsi sumber daya dan biaya operasional.Red Hat AI Inference Server hadir sebagai solusi untuk mengatasi tantangan ini dengan menyediakan toolset kompresi model, repositori model teroptimasi, dan kapabilitas multi-akselerator yang mumpuni.

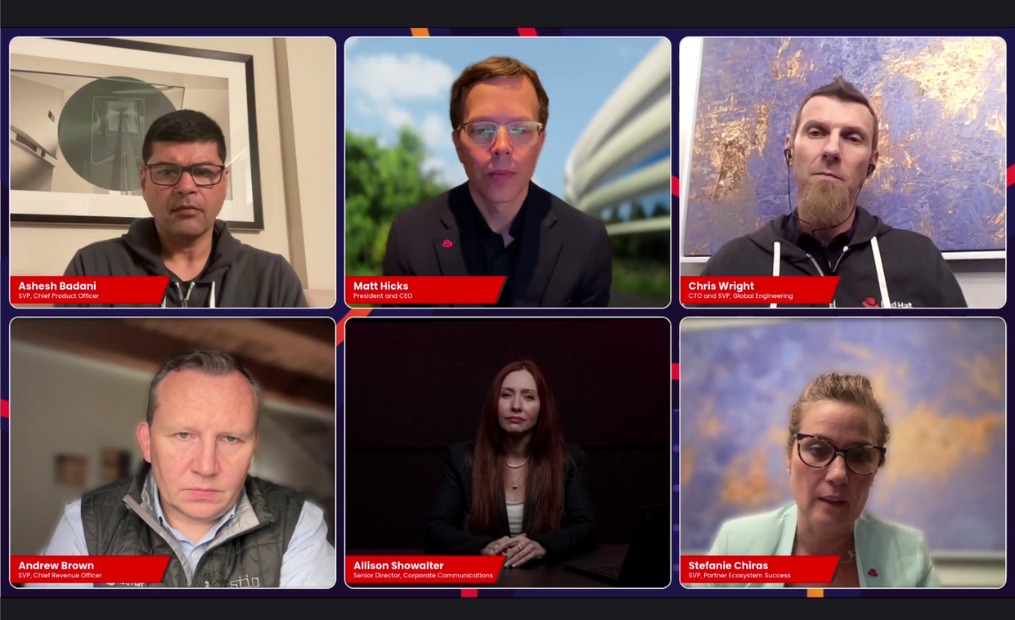

Menurut Matt Hicks, President and CEO of Red Hat, inferensi adalah tempat AI generatif terwujud. "Red Hat AI Inference Server memastikan bahwa respons cepat dan akurat dari AI dapat dijalankan secara hemat sumber daya, mendukung model apapun, akselerator apapun, dan lingkungan manapun."

vLLM: Fondasi Terbuka untuk Inferensi AI Masa Depan

Red Hat membangun AI Inference Server di atas proyek komunitas vLLM, yang diprakarsai oleh University of California, Berkeley pada tahun 2023. Proyek ini telah menjadi standar de facto untuk inferensi AI dengan dukungan throughput tinggi, continuous batching, multi-GPU, serta konteks input besar. vLLM juga kompatibel dengan beragam model populer seperti DeepSeek, Llama, Mistral, Phi, Nemotron, hingga model reasoning kelas enterprise, sehingga mempercepat integrasi model AI dari berbagai sumber ke dalam infrastruktur perusahaan.Keunggulan vLLM tidak hanya terletak pada performa teknisnya, tetapi juga pada keterbukaannya terhadap inovasi komunitas dan integrasi langsung dengan model-model day-zero melalui Hugging Face.

Red Hat pun menghadirkan repositori model-model AI terverifikasi dan siap pakai, memungkinkan organisasi mempercepat produktivitas AI mereka dengan peningkatan efisiensi hingga 2–4 kali lipat tanpa mengorbankan akurasi.

Dukungan Luas dari Ekosistem Teknologi

Peluncuran Red Hat AI Inference Server mendapat sambutan hangat dari mitra strategis Red Hat. AMD menyatakan bahwa server ini dapat memaksimalkan performa GPU AMD Instinct, sementara Cisco menekankan kolaborasi mereka dengan Red Hat dalam membangun penerapan AI yang mudah diakses dan scalable.Intel juga turut mendukung dengan mengintegrasikan akselerator Intel Gaudi, dan NVIDIA menawarkan interoperabilitas penuh melalui Red Hat AI Inference Server yang berjalan di atas NVIDIA Enterprise AI stack.

Chris Wright, CTO and SVP Global Engineering menyatakan, Red Hat AI Inference Server memberikan landasan baru untuk mendorong AI ke arah efisiensi dan skalabilitas. "Kami antusias untuk terus memperluas kemitraan strategis ini demi menghadirkan solusi AI yang adaptif dan praktis di masa depan.”

Visi Red Hat: Inferensi Terbuka untuk Semua

Red Hat mengusung visi ambisius: menciptakan standar terbuka untuk inferensi generatif AI yang dapat berjalan di model apapun, akselerator apapun, dan cloud apapun. Dengan memanfaatkan vLLM sebagai fondasi dan mengembangkan infrastruktur pendukung seperti llm-d untuk inferensi terdistribusi, Red Hat ingin mengulangi kesuksesannya dalam membawa Linux menjadi fondasi TI modern kali ini dalam ranah AI.Dengan Red Hat AI Inference Server, organisasi tidak hanya mendapat akses ke teknologi inferensi AI paling mutakhir, tetapi juga memperoleh kebebasan penuh dalam menyesuaikan implementasi AI mereka, baik untuk kebutuhan edge, on-premise, maupun public cloud, tanpa dikekang oleh infrastruktur.

(Valesca Saputra)

Cek Berita dan Artikel yang lain di

Google News