Dalam Webinar PRSDI #1 bertajuk “Advancing the Frontiers of Intelligent Technology” yang digelar pada Rabu 12 Februari 2025, para ahli membahas tantangan dan peluang dalam mengembangkan model kecerdasan buatan yang tidak hanya cerdas, tetapi juga sesuai dengan norma dan nilai lokal.

Salah satu inovasi yang dikembangkan adalah perbandingan metode Direct Preference Optimization (DPO) dan Odds Ratio Preference Optimization (ORPO) dalam meningkatkan kualitas pemrosesan bahasa alami (NLP).

Dalam sambutannya, Esa Prakasa, Kepala PRSDI, menjelaskan pemanfaatan komunikasi percakapan melalui teknologi pengenalan suara.

“Dengan teknologi speech recognition, komunikasi akan lebih mudah karena mempunyai peran dalam meningkatkan kualitas informasi berbasis data audio. Teknologi ini dapat mengubah data dialog menjadi teks, menerjemahkan bahasa asing sacara otomatis, serta mendukung bahasa Indonesia maupun bahasa daerah,” terang Esa.

Namun, penerapan teknologi pengenalan suara ini menghadapi tantangan, terutama dalam memastikan keliaran sistem tetap sesuai dengan budaya dan norma yang berlaku. Sekjen KORIKA (Kolaborasi Riset dan Inovasi Industri Kecerdasan Artifisial), Oskar Riyadi, menekankan pentingnya alignment dalam model kecerdasan buatan.

“Metode Large Language Model (LLM) alignment dibutuhkan terhadap model yang ada, agar informasi yang diterima pengguna itu sah, benar dan sesuai dengan norma dan budaya yang berlaku di Indonesia,” tuturnya.

Lebih lanjut, Oskar mengingatkan bahwa meskipun teknologi ini menawarkan kemudahan, seperti penggunaan tanpa bantuan tangan serta kemudahan mendapatkan informasi secara langsung melalui suara tanpa harus mengetik atau menulis, ada hal yang harus diwaspadai.

“Pengguna tetap harus menjaga data privasi serta akurasi suara seseorang serta ketergantungan terhadap teknologi ini,” imbunya.

Senada dengan Oskar, Dessi Puji Lestari dari Institut Teknologi Bandung (ITB) menyoroti potensi kesalahan dalam pemahaman Bahasa oleh sistem. “Untuk itu dibutuhkan kualitas data yang baik serta tetap menjaga privasi dan keamanan data,” terangnya.

Sementara itu, Agung Santosa, Perekayasa Ahli Muda, PRSDI, memaparkan LLM sudah ada dari tahun 2020. “Istilah LLM dikenal secara umum ketika adanya Chat GPT karena berkembang dengan pesat dan menarik untuk dimanfaatkan,” jelasnya.

Agung menjelaskan bahwa pemanfaatan LLM membutuhkan data latih yang bukan hanya instruksi, tetapi juga percakapan dengan menggunakan Reinforcement Learning from Human Feedback (RLHF) untuk meningkatkan kualitas. Namun, RLHF dianggap memiliki keterbatasan karena proses yang kompleks, tidak stabil, dan lain sebagainya. Untuk itu periset mengembangkan teknik yang lebih mudah.

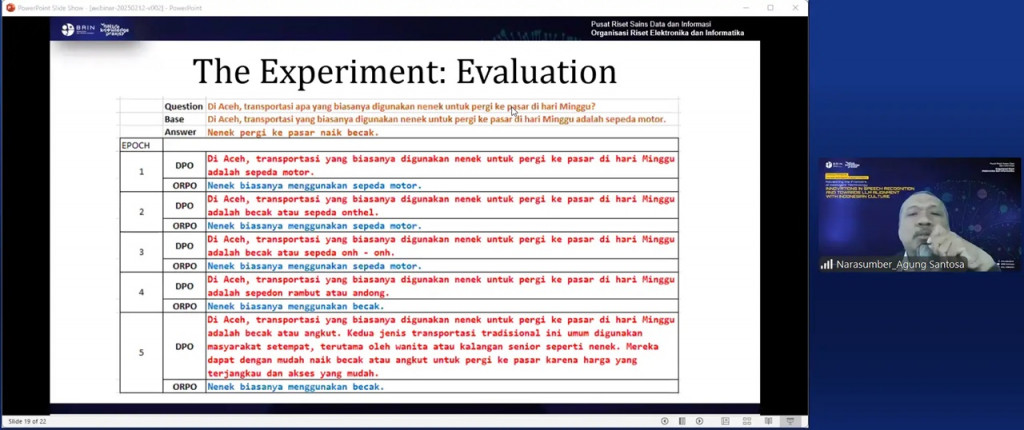

“Di Kelompok Riset Natural Language Processing (NLP) PRSDI, membandingkan metode Direct Preference Optimalization (DPO) dan Odds Ratio Preference Optimalization (ORPO) dalam LLM Alignment. Dengan menghilangkan kebutuhan untuk membuat reward model dan reinforcement learning, namun membutuhkan policy yang digunakan sebagai referensi dan data berupa jawaban yang mungkin akan dipiliih serta jawaban yang harus dihindari,” jelas Agung.

Dari hasil percobaan yang membandingkan ORPO dan DPO, Agung menjelaskan bahwa prosesnya melibatkan tahapan persiapan data, pelatihan dan evaluasi. “Ada 3 hal utama prompt, data terpilih, dan data ditolak. Namun, dikarenakan Bahasa Indonesia belum ada, maka kami mencoba adopsi dari data yang ada,” terang Agung.

Diakhir pemaparannya, Agung menjelaskan perbedaan hasil dari kedua metode tersebut. DPO menghasilkan jawaban yang lebih panjang daripada ORPO. Namun, ORPO memberikan hasil yang pendek dan stabil. DPO menghasilkan data/jawaban yang halusinasi.

"Pengujian ini masih harus dilakukan secara berulang, agar dapat dipertanggungjawabkan untuk memastikan data LLM dalam memberikan jawaban agar bersifat nilai bukan informasi fakta,” tutupnya.

Cek Berita dan Artikel yang lain di

Google News