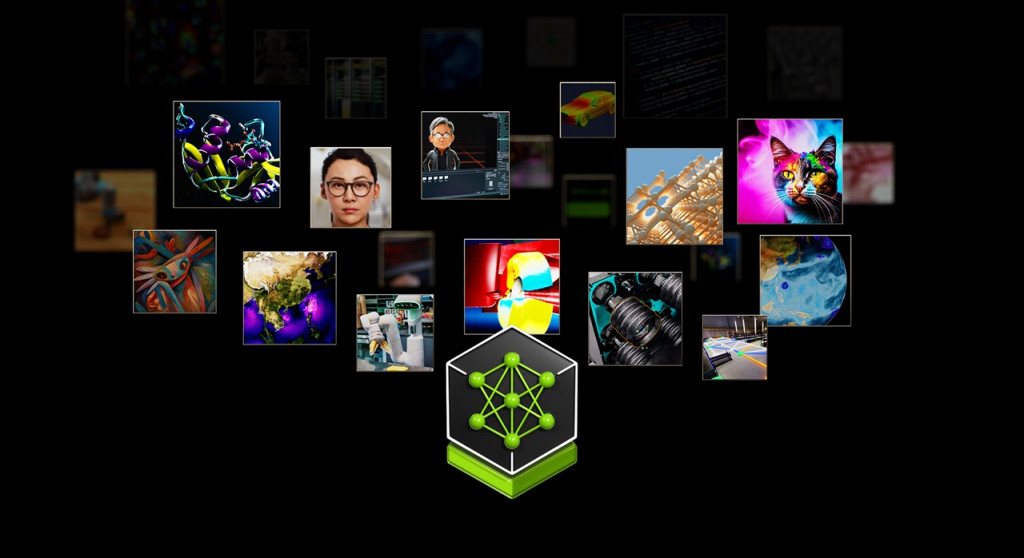

Dibangun di atas platform NVIDIA CUDA, katalog layanan mikro cloud-native mencakup layanan mikro NVIDIA NIM untuk inferensi yang dioptimalkan pada lebih dari dua lusin model AI populer dari NVIDIA dan ekosistem mitranya.

Selain itu, kit, pustaka, dan alat pengembangan perangkat lunak yang dipercepat NVIDIA kini dapat diakses sebagai layanan mikro NVIDIA CUDA-X untuk retrieval-augmented generation (RAG), guardrail, pemrosesan data, HPC, dan banyak lagi. NVIDIA juga secara terpisah mengumumkan lebih dari dua lusin layanan mikro NIM dan CUDA-X layanan kesehatan.

Pilihan layanan mikro yang dikurasi menambahkan lapisan baru pada platform komputasi full-stack NVIDIA. Lapisan ini menghubungkan ekosistem AI dari pengembang model, penyedia platform, dan perusahaan dengan jalur terstandar untuk menjalankan model AI khusus yang dioptimalkan untuk basis terpasang CUDA NVIDIA yang terdiri dari ratusan juta GPU di cloud, pusat data, workstation, dan PC.

Di antara perusahaan pertama yang mengakses layanan mikro AI generatif NVIDIA yang tersedia di NVIDIA AI Enterprise 5.0 adalah penyedia platform aplikasi, data, dan keamanan siber terkemuka termasuk Adobe, Cadence, CrowdStrike, Getty Images, SAP, ServiceNow, dan Shutterstock.

“Platform perusahaan yang sudah mapan mempunyai banyak sekali data yang dapat diubah menjadi kopilot AI generatif,” kata Jensen Huang, pendiri dan CEO NVIDIA. “Dibuat dengan ekosistem mitra kami, layanan mikro AI dalam container ini adalah landasan bagi perusahaan di setiap industri untuk menjadi perusahaan AI.”

Penerapan Kecepatan Layanan Mikro Inferensi NIM dari Minggu hingga Menit

Layanan mikro NIM menyediakan container siap pakai yang didukung oleh perangkat lunak inferensi NVIDIA — termasuk Triton Inference Server dan TensorRT-LLM — yang memungkinkan pengembang mengurangi waktu penerapan dari minggu ke menit.

Mereka menyediakan API standar industri untuk domain seperti bahasa, ucapan, dan penemuan obat guna memungkinkan pengembang dengan cepat membangun aplikasi AI menggunakan data milik mereka yang dihosting dengan aman di infrastruktur mereka sendiri. Aplikasi-aplikasi ini dapat ditingkatkan sesuai permintaan, memberikan fleksibilitas dan kinerja untuk menjalankan AI generatif dalam produksi pada platform komputasi yang dipercepat.

Layanan mikro NIM menyediakan wadah AI produksi tercepat dan berkinerja tertinggi untuk menerapkan model dari NVIDIA, A121, Adept, Cohere, Getty Images, dan Shutterstock serta model terbuka dari Google, Hugging Face, Meta, Microsoft, Mistral AI, dan Stability AI.

ServiceNow mengumumkan bahwa mereka menggunakan NIM untuk mengembangkan dan menerapkan kopilot khusus domain baru dan aplikasi AI generatif lainnya dengan lebih cepat dan lebih hemat biaya.

Pelanggan akan dapat mengakses layanan mikro NIM dari Amazon SageMaker, Google Kubernetes Engine, dan Microsoft Azure AI, serta berintegrasi dengan kerangka kerja AI populer seperti Deepset, LangChain, dan LlamaIndex.

Layanan Mikro CUDA-X untuk RAG, Pemrosesan Data, Guardrail, HPC

Layanan mikro CUDA-X menyediakan elemen penyusun menyeluruh untuk persiapan, penyesuaian, dan pelatihan data guna mempercepat pengembangan AI produksi di seluruh industri.

Untuk mempercepat adopsi AI, perusahaan dapat menggunakan layanan mikro CUDA-X termasuk NVIDIA Riva untuk AI ucapan dan terjemahan yang dapat disesuaikan, NVIDIA cuOpt untuk pengoptimalan perutean, serta NVIDIA Earth-2 untuk simulasi iklim dan cuaca resolusi tinggi.

Layanan mikro NeMo Retriever memungkinkan pengembang menghubungkan aplikasi AI mereka ke data bisnis mereka — termasuk teks, gambar, dan visualisasi seperti grafik batang, plot garis, dan diagram lingkaran — untuk menghasilkan respons yang sangat akurat dan relevan secara kontekstual.

Dengan kemampuan RAG ini, perusahaan dapat menawarkan lebih banyak data kepada kopilot, chatbot, dan alat produktivitas AI generatif untuk meningkatkan akurasi dan wawasan.

Layanan mikro NVIDIA NeMo tambahan akan segera hadir untuk pengembangan model kustom. Ini termasuk Kurator NVIDIA NeMo untuk membuat kumpulan data yang bersih untuk pelatihan dan pengambilan, Penyesuai NVIDIA NeMo untuk menyempurnakan LLM dengan data khusus domain, NVIDIA NeMo Evaluator untuk menganalisis kinerja model AI, serta guardrail NVIDIA NeMo untuk LLM.

Ekosistem Meningkatkan Platform Perusahaan dengan Layanan Mikro AI Generatif

Selain penyedia aplikasi terkemuka, penyedia data, infrastruktur, dan platform komputasi di seluruh ekosistem NVIDIA juga bekerja sama dengan layanan mikro NVIDIA untuk menghadirkan AI generatif ke perusahaan.

Penyedia platform data terkemuka termasuk Box, Cloudera, Cohesity, Datastax, Dropbox, dan NetApp bekerja sama dengan layanan mikro NVIDIA untuk membantu pelanggan mengoptimalkan saluran RAG mereka dan mengintegrasikan data milik mereka ke dalam aplikasi AI generatif. Snowflake memanfaatkan NeMo Retriever untuk memanfaatkan data perusahaan guna membangun aplikasi AI.

Perusahaan dapat menerapkan layanan mikro NVIDIA yang disertakan dengan NVIDIA AI Enterprise 5.0 di seluruh infrastruktur pilihan mereka, seperti cloud terkemuka Amazon Web Services (AWS), Google Cloud, Azure, dan Oracle Cloud Infrastructure.

Layanan mikro NVIDIA juga didukung di lebih dari 400 Sistem Bersertifikasi NVIDIA, termasuk server dan stasiun kerja dari Cisco, Dell Technologies, Hewlett Packard Enterprise (HPE), HP, Lenovo, dan Supermicro. Secara terpisah, HPE mengumumkan ketersediaan solusi komputasi perusahaan HPE untuk AI generatif, dengan rencana integrasi NIM dan model NVIDIA AI Foundation ke dalam perangkat lunak AI HPE.

Layanan mikro NVIDIA AI Enterprise hadir pada platform perangkat lunak infrastruktur termasuk VMware Private AI Foundation dengan NVIDIA.

Red Hat OpenShift mendukung layanan mikro NVIDIA NIM untuk membantu perusahaan lebih mudah mengintegrasikan kemampuan AI generatif ke dalam aplikasi mereka dengan kemampuan yang dioptimalkan untuk keamanan, kepatuhan, dan kontrol. Canonical menambahkan dukungan Charmed Kubernetes untuk layanan mikro NVIDIA melalui NVIDIA AI Enterprise.

Ekosistem NVIDIA yang terdiri dari ratusan mitra AI dan MLOps, termasuk Abridge, Anyscale, Dataiku, DataRobot, Glean, H2O.ai, Securiti AI, Scale AI, OctoAI, dan Weights & Biases, menambahkan dukungan untuk layanan mikro NVIDIA melalui NVIDIA AI Enterprise.

Apache Lucene, Datastax, Faiss, Kinetica, Milvus, Redis, dan Weaviate adalah beberapa penyedia pencarian vektor yang bekerja dengan layanan mikro NVIDIA NeMo Retriever untuk mendukung kemampuan RAG yang responsif bagi perusahaan.

Pengembang dapat bereksperimen dengan layanan mikro NVIDIA di ai.nvidia.com tanpa biaya. Perusahaan dapat menerapkan layanan mikro NIM tingkat produksi dengan NVIDIA AI Enterprise 5.0 yang berjalan pada Sistem Bersertifikasi NVIDIA dan platform cloud terkemuka.

Cek Berita dan Artikel yang lain di

Google News