Untuk mendukung upaya ini, NVIDIA mengumumkan ketersediaan empat layanan mikro NIM baru yang memungkinkan pengembang untuk lebih mudah membangun dan menerapkan aplikasi AI generatif berkinerja tinggi.

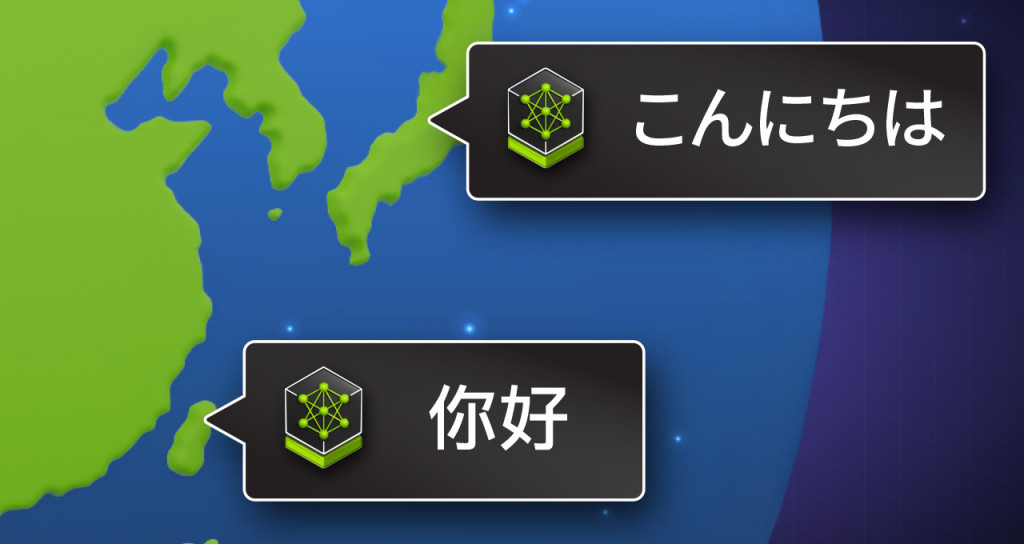

Layanan mikro mendukung model komunitas populer yang disesuaikan untuk memenuhi kebutuhan regional. Mereka meningkatkan interaksi pengguna melalui pemahaman yang akurat dan respons yang lebih baik berdasarkan bahasa lokal dan warisan budaya.

Di kawasan Asia-Pasifik saja, pendapatan perangkat lunak AI generatif diperkirakan akan mencapai USD48 miliar pada tahun 2030 — naik dari USD5 miliar tahun ini, menurut ABI Research. Llama-3-Swallow-70B, dilatih tentang data Jepang, dan Llama-3-Taiwan-70B, yang dilatih pada data Mandarin, adalah model bahasa daerah yang memberikan pemahaman yang lebih dalam tentang hukum, peraturan, dan adat istiadat setempat.

Keluarga model RakutenAI 7B, dibangun di atas Mistral-7B, dilatih pada kumpulan data bahasa Inggris dan Jepang, dan tersedia sebagai dua layanan mikro NIM yang berbeda untuk Obrolan dan Instruksi. Model-model ini telah mencapai skor terdepan di antara model bahasa Jepang terbuka dalam bahasa Jepang, mendapatkan skor rata-rata teratas dalam tolok ukur LM Evaluation Harness yang dilakukan dari Januari hingga Maret 2024.

Melatih model bahasa besar (LLM) pada bahasa daerah meningkatkan efektivitas outputnya dengan memastikan komunikasi yang lebih akurat dan bernuansa, karena lebih memahami dan mencerminkan seluk-beluk budaya dan linguistik.

Model ini menawarkan kinerja terkemuka untuk pemahaman bahasa Jepang dan Mandarin, tugas hukum regional, menjawab pertanyaan, dan terjemahan dan ringkasan bahasa dibandingkan dengan LLM dasar seperti Llama 3.

Negara-negara di seluruh dunia — dari Singapura, Uni Emirat Arab, Korea Selatan dan Swedia hingga Prancis, Italia, dan India — berinvestasi dalam infrastruktur AI yang berdaulat.

Layanan mikro NIM yang baru memungkinkan bisnis, lembaga pemerintah, dan universitas untuk menghosting LLM asli di lingkungan mereka sendiri, memungkinkan pengembang untuk membangun copilot, chatbot, dan asisten AI tingkat lanjut.

Mengembangkan Aplikasi dengan Sovereign AI

Pengembang dapat dengan mudah menerapkan model AI berdaulat, yang dikemas sebagai layanan mikro NIM, ke dalam produksi sambil mencapai peningkatan kinerja.

Layanan mikro, yang tersedia dengan NVIDIA AI Enterprise, dioptimalkan untuk inferensi dengan pustaka sumber terbuka NVIDIA TensorRT-LLM.

Layanan mikro NIM untuk Llama 3 70B — yang digunakan sebagai model dasar untuk layanan mikro NIM Llama–3-Swallow-70B dan Llama-3-Taiwan-70B baru — dapat memberikan throughput hingga 5x lebih tinggi. Ini menurunkan total biaya menjalankan model dalam produksi dan memberikan pengalaman pengguna yang lebih baik dengan mengurangi latensi.

Layanan mikro NIM baru tersedia saat ini sebagai antarmuka pemrograman aplikasi (API) yang dihosting.

Memanfaatkan NVIDIA NIM untuk Hasil AI Generatif yang Lebih Cepat dan Lebih Akurat

Layanan mikro NIM mempercepat penerapan, meningkatkan kinerja secara keseluruhan, dan memberikan keamanan yang diperlukan untuk organisasi di seluruh industri global, termasuk perawatan kesehatan, keuangan, manufaktur, pendidikan, dan hukum.

Institut Teknologi Tokyo menyempurnakan Llama-3-Swallow 70B menggunakan data berbahasa Jepang.

"LLM bukanlah alat mekanis yang memberikan manfaat yang sama bagi semua orang. Mereka adalah alat intelektual yang berinteraksi dengan budaya dan kreativitas manusia. Pengaruhnya saling menguntungkan di mana tidak hanya model yang dipengaruhi oleh data yang kita latih, tetapi juga budaya kita dan data yang kita hasilkan akan dipengaruhi oleh LLM," kata Rio Yokota, profesor di Pusat Informasi dan Komputasi Ilmiah Global di Institut Teknologi Tokyo.

"Oleh karena itu, sangat penting untuk mengembangkan model AI berdaulat yang mematuhi norma budaya kita. Ketersediaan Llama-3-Swallow sebagai layanan mikro NVIDIA NIM akan memungkinkan pengembang untuk dengan mudah mengakses dan menerapkan model untuk aplikasi Jepang di berbagai industri."

Misalnya, sebuah perusahaan AI Jepang, Preferred Networks, menggunakan model tersebut untuk mengembangkan model khusus perawatan kesehatan yang dilatih pada korpus unik data medis Jepang, yang disebut Llama3-Preferred-MedSwallow-70B, yang menempati peringkat teratas pada Ujian Nasional Jepang untuk Dokter.

Rumah Sakit Memorial Chang Gung (CGMH), salah satu rumah sakit terkemuka di Taiwan, sedang membangun Layanan Inferensi AI (AIIS) yang dibuat khusus untuk memusatkan semua aplikasi LLM dalam sistem rumah sakit. Menggunakan Llama 3-Taiwan 70B, ini meningkatkan efisiensi staf medis garis depan dengan bahasa medis yang lebih bernuansa yang dapat dipahami pasien.

"Dengan memberikan panduan instan yang sesuai dengan konteks, aplikasi AI yang dibangun dengan LLM berbahasa lokal merampingkan alur kerja dan berfungsi sebagai alat pembelajaran berkelanjutan untuk mendukung pengembangan staf dan meningkatkan kualitas perawatan pasien," kata Dr. Changfu Kuo, direktur Pusat Kecerdasan Buatan dalam Kedokteran di CGMH, Cabang Linko.

Pegatron yang berbasis di Taiwan, pembuat perangkat elektronik, akan mengadopsi layanan mikro Llama 3-Taiwan 70B NIM untuk aplikasi yang menghadap ke internal dan eksternal. Ini telah mengintegrasikannya dengan Sistem AI Agen PEGAAi untuk mengotomatiskan proses, meningkatkan efisiensi dalam manufaktur dan operasi.

Llama-3-Taiwan 70B NIM juga digunakan oleh produsen petrokimia global Chang Chun Group, perusahaan papan sirkuit cetak terkemuka dunia Unimicron, perusahaan media yang berfokus pada teknologi TechOrange, perusahaan layanan kontrak online LegalSign.ai dan startup AI generatif APMIC. Perusahaan-perusahaan ini juga berkolaborasi dalam model terbuka.

Membuat Model Perusahaan Kustom

Meskipun model AI regional dapat memberikan respons yang bernuansa budaya dan terlokalisasi, perusahaan masih perlu menyempurnakannya untuk proses bisnis dan keahlian domain mereka.

NVIDIA AI Foundry adalah platform dan layanan yang mencakup model fondasi populer, NVIDIA NeMo untuk penyempurnaan, dan kapasitas khusus pada NVIDIA DGX Cloud untuk menyediakan solusi full-stack kepada pengembang untuk membuat model fondasi khusus yang dikemas sebagai layanan mikro NIM.

Selain itu, pengembang yang menggunakan NVIDIA AI Foundry memiliki akses ke platform perangkat lunak NVIDIA AI Enterprise, yang memberikan keamanan, stabilitas, dan dukungan untuk penerapan produksi.

NVIDIA AI Foundry memberi pengembang alat yang diperlukan untuk lebih cepat dan mudah membangun dan menerapkan layanan mikro NIM bahasa regional kustom mereka sendiri untuk mendukung aplikasi AI, memastikan hasil yang sesuai secara budaya dan bahasa bagi pengguna mereka.

(Kari Briski, Vice President, AI Software, NVIDIA)

Cek Berita dan Artikel yang lain di

Google News