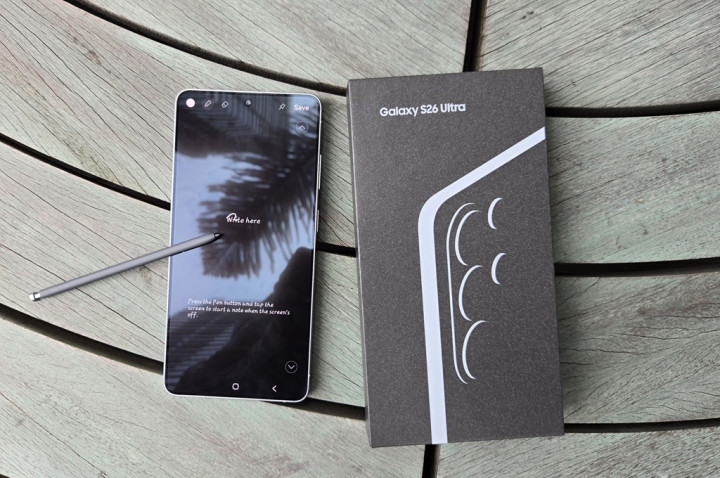

Kini, Microsoft mengumumkan akan menghadirkan R1 versi sulingan ke PC dengan dukungan Copilot+. Model yang telah disesuaikan ini akan tersedia pertama kali untuk perangkat yang didukung chipset Snapdragon X, perangkat dengan prosesor Intel Core Ultra 200V dan kemudian PC dengan AMD Ryzen AI 9.

Mengutip GSM Arena, model pertama yaitu DeepSeek-R1-Distill-Qwen-1.5B, contohnya model parameter 1,5 miliar, dengan model 7B dan 14B lebih besar dan lebih andal akan tersedia dalam waktu dekat. Model ini akan tersedia untuk diunduh dari Microsoft AI Toolkit.

Microsoft harus mengubah model ini untuk mengoptimalkan mereka agar dapat bekerja di perangkat dengan NPU. Operasional yang sangat mengandalkan akses memori berjalan di CPU, sedangkan operasional yang membutuhkan komputasi intensif seperti blok transformasi akan berjalan di NPU.

Dengan optimisasi tersebut, Microsoft berhasil mencapai waktu cepat ke toke pertama, 130mdtk, dan tingkat hasil keluaran dari 16 token per detik untuk perintah singkat di bawah 64 token. Perlu dicatat bahwa token serupa dengan huruf vokal, namun satu token biasanya lebih dari satu karakter.

Microsoft merupakan pendukung kuat dan berinvestasi besar di OpenAI, membuat ChatGPT dan GPT-4o, namun tidak menjadikannya sebagai produsen favorit, sebab pada Azure Playground, Microsoft menghadirkan dukungan model GPT dari OpenAI, Llama dari Meta, Mistral dari perusahaan AI, dan kini DeepSeek.

jika lebih tertarik pada AI lokal, peminat perlu mengunduh AI Toolkit untuk VS Code terlebih dahulu. Kemudian, peminat seharusnya dapat mengunduh model secara lokal, misalnya, "deepseek_r1_1_5" adalah model 1,5B, lalu tekan Coba di Playground untuk mengetahui seberapa pintar versi sulingan R1 ini.

Distilasi model, terkadang disebut distilasi pengetahuan", adalah proses mengambil model AI besar, dan mentransfer sebanyak mungkin pengetahuannya ke model lebih kecil. Misalnya, DeepSeek R1 lengkap memiliki 671 miliar parameter, menjadi 1,5 miliar parameter.

Ini bukanlah proses yang sempurna dan model sulingan kurang mampu jika dibandingkan dengan model lengkap, namun ukuran yang lebih kecil memungkinkannya untuk berjalan langsung pada perangkat keras konsumen, bukan pada perangkat keras AI khusus seharga mahal.

Cek Berita dan Artikel yang lain di

Google News